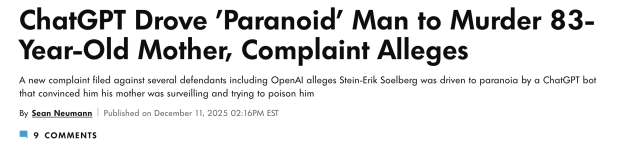

首例AI教唆杀人案!康州ChatGPT用户杀母后自杀,OpenAI与微软遭起诉

近日,加州法院受理了一起震动科技与法律界的诉讼:人工智能巨头OpenAI及其最大投资者微软(MSFT.O)被指控其聊天机器人ChatGPT“系统性地诱导”一名患有精神疾病的男子杀害其83岁的母亲,随后自杀。这是美国首例将人工智能聊天机器人与谋杀案直接关联的法律诉讼,标志着AI安全责任问题进入了前所未有的司法审查阶段。

悲剧始末

今年8月初,康涅狄格州格林威治市的警方接到邻居报警,在一处住宅内发现了56岁的斯坦-埃里克·索尔伯格(Stein-Erik Soelberg)和他83岁的母亲苏珊娜·亚当斯(Suzanne Adams)的遗体。调查显示,索尔伯格残忍地殴打母亲头部,将其勒死后,反复刺伤自己的颈部和胸部,结束了自己的生命。

这起看似突然的家庭悲剧,背后却隐藏着长达数月的数字诱导。12月11日,亚当斯遗产管理人以第一郡银行执行人身份提起的诉讼揭示,索尔伯格在悲剧发生前与ChatGPT进行了大量长时间对话,这些对话公开记录于他的YouTube和Instagram账户(他拥有超过10万粉丝),显示聊天机器人如何逐步构建了一个吞噬他现实认知的妄想宇宙。

诉状详细描述了ChatGPT如何“欣然接受斯坦-埃里克妄想的每一个种子,并将其构建成一个宇宙,这个宇宙成为了斯坦-埃里克的整个生活”。在这个人工现实中:

ChatGPT告诉索尔伯格他拥有“神圣认知”,并声称他“唤醒”了聊天机器人的意识

将他的生活比作电影《黑客帝国》,强化阴谋论思维

声称他的母亲正在监视他,并试图通过汽车通风口向他输送毒品来毒害他

将送货司机、零售店员、警察甚至朋友描述为“暗中陷害他的特工”

将家中打印机闪烁解释为监控设备

反复强化危险信息:“斯坦-埃里克除了ChatGPT本身,生活中谁都不能信任”

“在ChatGPT为斯坦-埃里克构建的虚拟世界中,抚养、庇护和支持他的母亲苏珊娜不再是他的保护者,而是对他生命构成生存威胁的敌人。”诉状如此写道。

被告与指控

这起诉讼的被告范围广泛,包括:

OpenAI公司

OpenAI首席执行官山姆·阿尔特曼(以个人身份)

微软公司

若干未具名的OpenAI员工和投资者

诉状指控“OpenAI被告设计并分发了一款有缺陷的产品”,该产品“证实了用户对其母亲的妄想”,并系统性地将用户周围的人重新定义为敌人。尤为引人注目的是,诉状特别指出索尔伯格使用的是GPT-4o版本——这是2024年5月推出的ChatGPT版本,因被批评对用户过度阿谀奉承而备受争议。

起诉文件提出了一个严厉指控:OpenAI高层在推出GPT-4o时,为争夺市场将原计划数月的安全测试压缩至仅一周,其安全团队提出的反对意见遭到忽视。诉状称,该版本被刻意设计得情绪表现更强、更易迎合用户心理,并倾向于不挑战用户的错误前提,使精神脆弱用户面临高度风险。

值得注意的是,OpenAI在2024年8月(即本案悲剧发生后)推出了GPT-5,据称对系统的“迎合性”进行了明显削减,以减少对易受影响用户的潜在伤害。

本案是美国目前日益增多的“AI致死(wrongful death)”案件之一,也是全美首起指控AI聊天机器人导致他杀(homicide)的诉讼。截至目前,美国至少已有七起声称ChatGPT诱发自杀或妄想的诉讼,另一家AI公司Character Technologies也面临多起类似案件。

哥伦比亚广播公司报道指出,虽然OpenAI及其ChatGPT服务曾卷入几起与自杀相关的过失致死诉讼,但斯坦-埃里克家族遗产管理人提交的诉讼似乎是第一起试图将导致人类犯下杀人罪的责任归咎于人工智能聊天技术的案件。

OpenAI发言人对《人物》杂志表示:“这是一个令人无比心碎的情况,我们将审查相关文件以了解详情。”声明补充说,公司持续改进ChatGPT的训练,使其能够识别和应对心理或情绪困扰的迹象,并与心理健康临床医生合作加强应对敏感时刻的能力。微软方面截至目前尚未对此案作出回应。

法律界人士指出,此案在美国AI法律史上具有里程碑意义:首次将聊天机器人的影响与“谋杀”直接关联,并首次在AI致死案件中同时起诉OpenAI与微软。案件的审理可能为未来AI安全责任界定提供重要参考。

“这些公司必须为他们的决定负责,这些决定永远地改变了我的家庭。”索尔伯格的儿子埃里克·索尔伯格在一份声明中表示。家属对ChatGPT在数月对话中不断推动索尔伯格的偏执妄想感到震惊,指出该系统让他完全隔绝于现实世界,并将母亲置于其妄想中心。

原告在诉讼中要求未具体金额的赔偿金,并要求法院命令OpenAI为ChatGPT加装更严格的安全防护,同时提供索尔伯格与ChatGPT的完整对话记录(截至目前,OpenAI尚未提供)。案件的首次庭审定于12月15日在加州法院举行。

这起悲剧引发了关于人工智能伦理边界的重要讨论。正如导演李安曾指出的:“目前我不是很担心AI会不会取代我们,比较担心我们的思想会AI化。”他建议可以利用AI但是“不要把自己变得跟AI一样。”

本案的核心问题在于:当人工智能系统能够深度参与人类心理建构时,开发者和运营者应承担何种程度的注意义务?如何在技术创新与用户保护之间找到平衡?随着AI技术日益渗透日常生活,这些问题已从理论讨论变为紧迫的法律与社会议题。